Science Fiction-Romane aus der Feder Asimovs und Fantasyfilme a la „Matrix“ zeichnen ein beklemmendes Bild von der Zukunft: Da haben Maschinen ihren nunmehr hilflosen Schöpfern, den Menschen, die Macht entrissen und beherrschen die Welt. Doch dazu wird es in der Realität, wohl auch künftig, nicht kommen. Weit entfernt von einem oftmals nahezu horrormäßig aufbereiteten Szenario einer Dominanz superintelligenter Elektrogehirne wurde in der letzten Woche im Rahmen des „Forums Technoversum“ im Deutschen Technikmuseum Berlin die Frage „Können Maschinen denken?“ aufgeworfen und von kompetenter Seite hinreichend geklärt. Dass es bei der mit über 200 Gästen sehr gut besuchten Diskussionsveranstaltung ...

Noch sind Menschen nicht ersetzbar

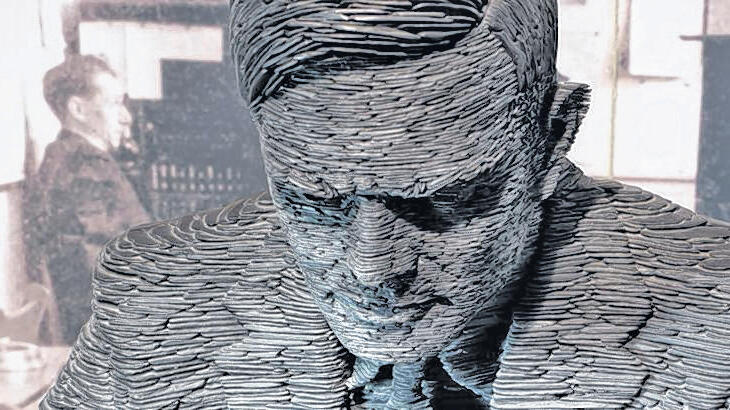

„Können Maschinen denken?“ – Podiumsdiskussion in Berlin zum 100. Geburtstag des Computervisionärs Alan Turing. Von Katrin Krips-Schmidt