Zu Beginn des Jahrhunderts – genauer am 6. Juni 2000 – veröffentlichte die Frankfurter Allgemeine Zeitung einen Essay des Software-Entwicklers Bill Joy. In dem ursprünglich für das renommierte Wired Magazin verfassten Aufsatz setzte sich Joy, eine Ikone des Silicon Valleys, kritisch mit dem Manuskript des von Ray Kurzweil verfassten, späteren Bestellers „The Age of Spiritual Machines“ auseinander. In dem Buch, das auf Deutsch unter dem Titel „Homo S@piens“ erschien, entfaltet der Computerpionier und Anhänger des Transhumanismus, der heute als Leiter der technischen Entwicklung im Vorstand von Google sitzt, seine Vision der „digitalen Revolution“: Bereits 2019 würden – so Kurzweil im Jahr 1999 – handelsübliche PCs den Menschen in allen Belangen der Intelligenz überflügeln. Um das Jahr 2029 könne dann das menschliche Gehirn gescannt und in einem Computer dupliziert werden. Gegen Ende des 21. Jahrhunderts kündige sich schließlich ein neuer Evolutionssprung an: Mensch und Maschine verschmölzen.

Verglichen mit dieser Kontroverse, nahm sich die diesjährige Jahrestagung des Deutschen Ethikrates unter der Überschrift „Autonome Systeme. Wie intelligente Maschinen unser Leben verändern“ so bescheiden wie übersichtlich aus. Denn statt um Cyborgs, sich selbstreplizierende Nanobots und Maschinen, die den Turing-Test bestehen, ging es am Mittwoch in Berlin lediglich um selbstfahrende Autos, Pflegeroboter und Kühlschränke, die Milch beim Lebensmittelhändler der Wahl nachbestellen, wenn diese sich ihrem Ende zuneigt. Wenig Science-Fiction, mehr Realität. Spannend war auch die.

Das lag interessanterweise nicht zuletzt an zwei Schwergewichten des Geistes – dem Philosophen Julian Nida-Rümelin und der Schriftstellerin Thea Dorn. Während nämlich der Inhaber des Lehrstuhls für Philosophie und politische Theorie an der Ludwig-Maximilians-Universität München und frühere Kulturstaatsminister im ersten Kabinett Schröder im Hauptvortrag am Mittag begründete, warum Maschinen keine Verantwortung übernehmen können, kritisierte die Schriftstellerin Thea Dorn in einer Art Nachbetrachtung zum Schluss der Tagung die Verwendung von Begriffen wie „Autonome Systeme“, „Lernen“ und „Intelligenz“ im Zusammenhang mit der Rede von Maschinen.

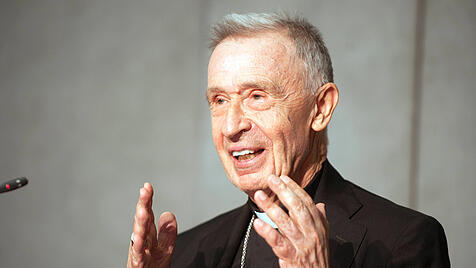

Aber der Reihe nach. Nach der Begrüßung und Einführung durch den Vorsitzenden des Ethikrates, Peter Dabrock, in welcher dieser die Frage aufwarf, ob der Mensch im „Meer der Datenströme“ überhaupt noch er selbst bleiben könne, oder ob er nicht stattdessen „mehr berauscht als bewusst“ von den „Miniaturverbesserungen unseres Alltages“ in eine „Unmündigkeitsfalle“ hineinstolpere, zeigte der frühere SAP-Chef und heutige Präsident der Deutschen Technikakademie acatech, Hennig Kagermann, auf, was hochautomatisierte Systeme bereits heute alles können und wie eine neue Generation sogenannter „autonomer Systeme“ entstehe.

Besondere Bedeutung komme dabei der Fähigkeit der Maschinen zum sogenannten „Deep Learning“ zu. Dabei ersetzten künstliche „neuronale“ Netze, die sich „klonen“ und prinzipiell in jedes andere Gerät einbringen ließen, die herkömmliche Programmierung. Im Ergebnis erlaube es eine solche Netzarchitektur Maschinen, komplizierte Konzepte selbstständig zu erlernen und komplexe Aufgaben zu lösen, ohne dass Menschen notwendig sind. Ferner könnten die Maschinen selbstständige „Entscheidungen“ treffen und sich dynamisch auch an für sie unbekannte Umgebungen anpassen. Einsatzfelder für solche „autonomen Systeme“ seien Anwendungen in der Industrieproduktion, im Bereich der Mobilität beziehungsweise dem automatisierten Fahren, in der Gebäudetechnik (Stichwort: Smart Home) sowie in Umgebungen, die für den Menschen besonders gefährlich seien, wie etwa der Weltraum oder die Tiefsee.

Kagermann, der diese Systeme grundsätzlich begrüßte und auf die Vorteile verwies, die er unter anderem in der Entlastung des Menschen von schwerer körperlicher Arbeit oder der Verringerung von Unfällen sah, die durch menschliches Versagen hervorgerufen würden, verschwieg jedoch auch nicht deren Risiken und Gefahren. So ließen sich die „Entscheidungen“, die „autonome Systeme“ träfen, oft weder erklären noch exakt vorhersagen. Auch besäßen nahezu alle autonome Systeme ein sogenanntes „Dual-Use-Potenzial“ und könnten daher sowohl zu zivilen als auch militärischen Zwecken eingesetzt werden. Derzeit sei ein Einsatz solcher Systeme noch nicht zu empfehlen, da ein hinreichendes Maß an Sicherheit noch nicht gegeben sei.

Kagermann widersprach der Befürchtung, dass solche „autonomen Systeme“ Menschen überflüssig machen könnten. Für alle Anwendungsfelder gelte vielmehr, dass mit den Maschinen Menschen unterstützt und ihre Fähigkeiten ergänzt, statt ersetzt würden. Der „acatech“-Präsident forderte einen „frühzeitigen und langfristig angelegten gesellschaftlichen Dialog, in dem Chancen und Risiken transparent gemacht und gegeneinander abgewogen werden“.

Dagegen bemängelte Katharina Zweig, Professorin an der Technischen Universität Kaiserslautern, die oft mangelhafte Qualität von Algorithmus-basierten, entscheidungsunterstützenden Systemen. Am Beispiel von algorithmischen Entscheidungssystemen für Richter in den USA, die die Rückfälligkeit von Kriminellen hervorsagen sollen und Fehlerquoten von weit über 50 Prozent aufwiesen, zeigte die Informatikerin, wie schwierig es sei, fehlerfreie Systeme zu entwickeln. So hänge die Gesamtqualität des Systems stets sehr stark von der Qualität der Daten ab, auf denen es basiere. Deren Selektion wiederum beruhe auf subjektiven Entscheidungen, die das Endergebnis erheblich verändern könnten. Daher sei „die Entwicklung qualitätssichernder Prozesse“ sowie deren „Implementierung, Wartung und kontinuierlichen Verbesserung“ dringend erforderlich. Ferner bedürfe es einer gesamtgesellschaftlichen Diskussion darüber, welche gesellschaftlichen Prozesse sich überhaupt für algorithmische Entscheidungssysteme eignen und nach welchen Kriterien sie optimiert werden sollen“.

Julian Nida-Rümelin begann seine Ausführungen mit dem Geständnis, er betrachte die Entwicklung sogenannter „autonomer Systeme“ grundsätzlich „ganz entspannt“. Was er allerdings „nicht entspannt“ sehe, sei die „Übertragung menschlicher Entscheidungssituation im Individualverkehr auf Computer“. So mache es einen „kategorialen Unterschied“, ob ein „Fahrer die Entscheidung treffe, sein Auto in den Abgrund zu steuern, um drei Kinder zu retten“, statt diese zu überfahren oder eine solche Entscheidung „in die Software“ eines selbstfahrenden Fahrzeugs „eingebaut“ sei. Da Verantwortung an „Intentionalität und Personalität“ gekoppelt sei und so alleine Menschen zukämen, sei die Zuschreibung von Verantwortung, die Teil der „conditio humana“ sei, nicht auf Maschinen übertragbar. Zwar seien die Entwicklung und der zunehmende Einsatz autonomer Systeme wünschenswert, „aber ethisch nur unter der Bedingung vertretbar, dass autonomen Systemen keine mentalen und speziell personalen Eigenschaften zugeschrieben“ würden. Eine starke künstliche Intelligenz sei sogar technikfeindlich, da man tatsächlich intelligenten Maschinen konsequenterweise Rechte und Würde zugestehen müsse, die ihrer Instrumentalisierung enge Grenzen setzen würden. Falls der Fall eintreten sollte, dass eine Maschine den Turing-Test korrekt bestehe, „dann dürfen Sie einen solchen Computer nicht mehr ausstellen“ und müsste „über Menschenrechte für autonome Systeme“ nachgedacht werden.

Ebenso wie Nida-Rümlin erntete auch Thea Dorn lang anhaltenden Applaus, als sie am Ende den Gebrauch der Sprache und die den Tag über verwandten Begriffe kritisierte. Maschinen „Autonomie“ sowie „Intelligenz“ und „Lernen“ zuzuschreiben, sei ein Missbrauch der Begriffe. Bedeute doch Autonomie, die Dorn „zu den Königstugenden des Menschen“ zählte, „sich selbst Ziele setzen zu können“. Dies sei einer Maschine jedoch nicht möglich. Ähnliches gelte für die Begriff des „Lernens“. Ziel jedes echten Lernens sei der Gebrauch der Vernunft, welcher auch darauf hinaus laufen können müsse, seinen Lehrern nicht mehr zu folgen. Dass Maschinen „in diesem Sinne lernen, wollen wir aber gerade nicht“, so Dorn. Statt von selbstlernenden autonomen Maschine, solle man besser von „voll automatisierten“ und „hochvernetzten“ Systemen sprechen. Da der Mensch jedoch zur „geistigen Trägheit“ neige, wenn er zu viele Kompetenzen an Maschinen abtrete, forderte Dorn, die sich in Berlin keineswegs als Maschinenstürmerin präsentierte, zum Schluss ein Nachdenken über „persönlichkeitsbildende Fitnessbänder“, mit denen sich individuelle und gesellschaftliche Resilienzen bilden ließen. Ein Vorschlag, der nicht nur beim Vorsitzenden des Ethikrates viel Anklang fand.